Eine Medienrevolution?

Die chinesische Kurzvideoplattform TikTok ging 2016 online und erreichte in der Rekordzeit von neun Monaten 100 Millionen Nutzer*innen. Dieser Erfolg des Unternehmens ByteDance wurde bis vor kurzem als bislang erstaunlichstes Beispiel für die rasanten Verbreitung digitaler Anwendungen breit diskutiert.

Bis dann ChatGPT kam und diesen Rekord eindeutig brach: ChatGPT, ein Chat-Bot, der im November 2022 von OpenAI eingeführt wurde, erreichte in zwei Monaten 100 Millionen Testbenutzer*innen. Dabei handelt es sich nicht um eine kommerzielle App, sondern bislang um eine experimentelle Website ohne nennenswertes User Interface Design.

Julia Schneider, Volkswirtschaftlerin und Comic-Essayistin («We need to talk, AI!»), auf die Frage, ob ChatGPT eine Revolution darstelle: «Medientechnisch sicher eine Revolution, die aus einer inkrementellen Evolution entstanden ist. Ich würde es mit der Entwicklung des Buchdrucks vergleichen – er revolutionierte die Verbreitung des Buches, ist aber nicht plötzlich entstanden» («Traum und Alptraum»). Darin liegt auch schon das wirklich Neue: Die Neugier vieler Millionen Menschen auf eine Technologie gepaart mit einer Infrastruktur, die diese auch befriedigen kann.

Technologisch nichts Neues?

Timo Daum ist Physiker, Hochschullehrer und Sachbuchautor, sein Arbeitsschwerpunkt ist der digitale Kapitalismus.

ChatGPT ist ein von OpenAI, einem US- amerikanischen Forschungslabor, entwickelter und im November 2022 veröffentlichter Chatbot. OpenAI wurde 2015 gegründet. Hat derzeit ganze 375 Mitarbeiter*innen (Victor / Holmes, 2023). Zu den Gründern und Geldgebern gehören Elon Musk und Peter Thiel, zwei der bekanntesten Tech-Entrepreneure bzw. -investoren aus dem Silicon Valley.

GPT steht für Generative Pre-trained Transformers, eine Familie von Sprachmodellen für künstliche Intelligenz, die überwachten und bestärkenden Lerntechniken einsetzt. Es handelt sich um eine mächtige Variante schon bestehender, letztlich auf Forschungen der 1980er Jahre aufbauenden Konzepten. Die Verbesserungen gegenüber Vorgängerversionen beruhen in erster Linie auf der «Überdimensionierung bestehender Techniken», wie Heaven betont (Heaven, 2023): Die Anzahl der Parameter, sprich der in Trainingszyklen veränderbaren Werte des zugrundeliegenden Modells in Version 3 von ChatGPT beträgt 175 Milliarden gegenüber 1,5 Milliarden in der Vorgängerversion GPT-2. Es wurde auch mit viel mehr Daten trainiert (Heaven). Ähnlich sieht es bei der Menge der Trainingsdaten aus.

Es handelt sich technologisch um eine Weiterentwicklung bestehender, teilweise jahrzehntealter Forschungen. Die Lernalgorithmen selbst sind dabei «erschreckend einfach», sie können meist «in ein paar hundert oder tausend Zeilen kodiert werden», erklärt der KI-Experte Domingos. (Domingos, S. 24). «Diese Algorithmen verwenden Statistiken, um Muster in großen Datenmengen zu finden» erläutert wiederum Ethem Alpaydin in seinem Standardwerk zu maschinellem Lernen (Alpaydin, S. 166). Wir haben es also mit einer Rekombination von Bestehendem, einer Skalierung bereits Bekanntem zu tun. Wie so oft in der Technikgeschichte erweisen sich vermeintlich «genuine(n) Schöpfungen» «größtenteils aus Bearbeitungen des Bestehenden» und «Ergebnis eines im Verlauf der Menschheitsgeschichte sich fortentwickelnden general intellect» (Eder, S. 66). Darauf komme ich gleich noch zurück.

Breite Anwendung aber keine «Künstliche Intelligenz»

Aus zwei Gründen haben wir es mit einer Renaissance dieser Technologie zu tun: Zum einen sind Methoden maschinellen Lernens dank günstiger und leistungsfähiger Computer-Hardware und der Reifung bestimmter Methoden an die Schwelle massenmarktfähiger Anwendungen gelangt. Hinzu kommt das Vorhandensein immenser Datenmengen in vielen Anwendungsbereichen, die meist automatisch und kostenlos anfallen, und die als Trainingsdaten für maschinelles Lernen bereitstehen.

Der chinesisch-amerikanische Schriftsteller und Forscher Kai-Fu Lee hat es ausdrückt: Wir sind in das Zeitalter der Implementierung eingetreten, KI-basierte Produkte erreichen Produktreife und erobern den Massenmarkt (Lee 2018). Auch Domingos betont, dass KI-gestützte Anwendungen im Alltag von Konsument*innen angekommen sind: «Dein Smartphone ist randvoll mit Lernalgorithmen. Sie sind fleißig dabei, Tippfehler zu korrigieren, gesprochene Befehle zu verstehen, Übertragungsfehler zu reduzieren, Barcodes zu erkennen und vieles mehr» (Domingos 2018, S. xii).

ChatGPT stellt aber keinen Einstieg in Allgemeine Künstliche Intelligenz dar. Es handelt sich nach wie vor um hochspezialisierte «nützliche Idioten» (Langley 2012), die in einem klar definierten Anwendungsbereich reüssieren (und auch das nicht fehlerfrei). Im Falle von ChatGPT das Zusammenfassen von längeren Texten und das Kompilieren, also das Produzieren eines Textes durch Zusammenstellen von Informationen, die aus anderen Quellen gesammelt wurden, beispielsweise von technischen, wissenschaftlichen und juristischen Texte zu einer präzisen Fragestellung.

Evgeny Morozov schlägt daher vor, den Begriff Künstliche Intelligenz auf den «Müllhaufen der Geschichte» zu werfen, er stamme aus der gleichen Zeit wie «Eiserner Vorhang», «Domino-Theorie» und «Sputnik-Moment». Denn auch bei ChatGPT erweise sich, dass «das, was wir heute als ‹künstliche Intelligenz› bezeichnen, weder künstlich noch intelligent» ist (Morozov, 2023).

Extraktion, Produktivkraft, Ausbeutung von User-Arbeit

Andreas Boes und Tobias Kämpf haben vorgeschlagen, den Siegeszug des Internets und seine Entwicklung zu einem «gesellschaftlich allgegenwärtigen digitalen Informationsraum» als «Produktivkraftsprung», der zugleich sogar «eine neue Produktionsweise des Kapitalismus» einleite (Boes, Kämpf, 2023, S. 2). Auch sie halten die Penetrationsgeschwindigkeit und -breite als ein entscheidendes Charakteristikum: «Der Informationsraum fungiert nicht als die Domäne einer kleinen Gruppe von Spezialisten, sondern durchdringt die ganze Gesellschaft mit großer Geschwindigkeit.» (Boes, Kämpf 3).

Beherrscht wird diese auf der Extraktion von Daten beruhende Produktionsweise von den Digitalkonzernen, sie verfügen über die Ressourcen – Datenmengen, die auf ihren Plattformen anfallen, aber auch die infrastrukturellen Ressourcen im Bereich Cloud Computing, marxistisch gesprochen: Sie sind die Besitzer der KI-Produktionsmittel (Srnicek 2019). Den Digitalkonzernen gelingt es, diese Ausbeutung unserer Arbeit (immer öfter unbezahlte User-Arbeit, diverseste Formen, immer weniger hingegen Lohnarbeit im materiellen Produktionsprozess) zu verfestigen, rechtlich und technologische abgesichert in Geräten und Apps zurückzuspielen. Das ist der vielleicht wichtigste Aspekt der heutigen KI– ihre Anwendung als datenextraktive, verwertbare Informationen erzeugende Maschine des Kapitals. Matteo Pasquinelli: «ursprüngliche Aneignung von Information durch das Kapital» (Pasquinelli, 2009). KI wird so zur «vorerst letzte Maschine des Kapitals» (Daum 2019)

General Intellect im Dienst des Kapitals

Ich schlage vor, die Debatte um ChatGPT aus der Perspektive des general intellect zu führen. In seinem berühmten «Maschinenfragment» entwirft Marx ein Szenario, in dem im Zuge der fortschreitenden Verwissenschaftlichung der Produktion und der Automatisierung von Abläufen der Anteil der unmittelbar vergegenständlichten Hand- oder Kopf-Arbeit immer weiter in den Hintergrund tritt. In letzter Konsequenz wird die unmittelbare Arbeit aus dem Produktionsprozess verdrängt und der general intellect, auf allgemeinem Wissen beruhende Technologie, wird zum entscheidenden Produktionsfaktor. Denn gibt es keine lebendige Arbeit mehr, dann auch keine Ausbeutung, keinen Mehrwert, keinen Profit – das Kapital verfehlt seinen Existenzzweck und verschwindet.

ChatGPT zu general intellect

Was sagt ChatGPT auf die Frage, was unter general intellect zu verstehen ist. Hier die Antwort. Seht selbst:

«Der Begriff ‹general intellect› wurde vom Philosophen Karl Marx geprägt, um das kollektive Wissen, die Fähigkeiten und Fertigkeiten einer Gesellschaft oder Gruppe von Menschen zu beschreiben, die für die Produktion von Gütern und Dienstleistungen notwendig sind.

Laut Marx bezieht sich der general intellect auf das angesammelte Wissen, die Bildung und die intellektuellen Fähigkeiten der Arbeiterklasse, die ein Produkt der gesellschaftlichen Entwicklung und Zusammenarbeit sind.

Marx argumentierte, dass mit der Entwicklung von Technologie und Automatisierung die Rolle der individuellen Arbeit abnehmen und die Bedeutung des general intellect zunehmen würde. Auf diese Weise wird der allgemeine Intellekt als eine Kraft für sozialen Wandel und Fortschritt angesehen, die zu mehr Effizienz, Produktivität und sozialem Wohlbefinden führt.

Heutzutage wird das Konzept des allgemeinen Intellekts verwendet, um die Rolle von Wissen und Informationen in der heutigen Gesellschaft zu analysieren, insbesondere im Kontext der digitalen Wirtschaft und des Aufstiegs der künstlichen Intelligenz.»

Das Konzept des general intellect ist dienlich, um den Produktivkraftsprung zu verstehen, in dem kollektives Wissen als unmittelbare Produktivkraft erscheint, als «Potential intelligenter Produktivkräfte» (Lotz, S. 9), aber gleichzeitig, auch dessen private Aneignung in den Blick zu bekommen. Denn, wie Eder bemerkt: «Anders als Marx es in seinem Maschinenfragment konstatierte, kollabiert die auf Tauschwert beruhende Produktion nicht einfach; stattdessen verändern sich Vorstellungen von Zeit und Arbeit durch die Maschinerie fundamental» (Eder, S. 26). Die Informationsmonopole des kontemporären Kapitalismus besetzen diesen paradoxen Ort: Sie nutzen öffentlich zugangliche Informationen, transformieren diese in einen privat orchestrierten Service, den sie uns hernach zur Verfügung stellten, woraus sie dann wiederum den Löwenanteil ihrer Einnahmen erwirtschaften (Daum 2017, S. 225). Wir haben es mit dem general intellect at work zu tun, ChatGPT ist schon «Kommunismus der Sachen» (Robert Kurz), aber im Dienst des Kapitals, nicht dieses überwindend, nicht sprengend.

Das digitale Kapital ist ständig bemüht, seinen Zugriff auf assets via deren immer wieder neu formulierter und ausgehandelter Kodifizierung sicherstellen, um seinen von Gesetz und Ordnung anerkannten und verteidigten Zugriff auf diese zu festigen (Pistor 2021). Katharina Pistor argumentiert dass Regeln, Gesetze, Standards, internationale Abkommen etc. einen legal code konstituieren, der für die langfristige Reproduktion des Kapitals unerlässlich ist Ebenso wie Waldman betont sie dabei den Prozess der ständigen Veränderung und Anpassung an veränderte Rahmenbedingungen. Das Kapital müsse seinen Zugriff auf assets via deren immer wieder neu formulierter und ausgehandelter Kodifizierung sicherstellen, um seinen von Gesetz und Ordnung anerkannten und verteidigten Zugriff auf diese zu festigen.

Es ist der general intellect am Werk, aber im Dienst des Kapitals – nicht sprengend, sondern ständige Veränderung des rechtlichen, politischen usw. Rahmens.

ChatGPT lässt sich aus Marx-Perspektive als Privatisierung von general intellect verstehen.

Jobs kommen und gehen

300 Millionen Arbeitsplätze könnten von der jüngsten KI-Welle betroffen sein, sagt Goldman Sachs (Toh, 2023). Forscher von OpenAI, den Machern von ChatGPT behaupteten kürzlich, ChatGPT habe das Zeug, eine große Anzahl von Jobs zu automatisieren. Das erinnert an die Hysterie um Carl Benedikt Freys und Michael Osbornes Publikation von 2013, die knapp die Hälfte aller Jobs verschwinden sahen binnen zwanzig Jahren. Prinzipielle Ersetzbarkeit wurde damals gleichgesetzt mit tatsächlicher Ersetzung. Das wiederholt sich gerade bei ChatGPT, worauf Aaron Benanav aufmerksam macht: «Eine ähnliche Methodik führte in der Studie von Frey und Osborne aus dem Jahr 2013 dazu, dass die Anfälligkeit für Automatisierung maßlos überschätzt wurde.» (Benanav 2023). Demgegenüber: Jobs ändern sich, einige verschwinden, aber viele entstehen auch neu; 60 Prozent der Jobs, die es heute gibt, gab es 1940 noch nicht.

Wichtig ist aber Folgendes, und auch da helfen uns Marx (und Alan Turing): Wenn mein Job demnächst von einer Maschine gemacht wird, oder «auf einer Maschine läuft», dann folgt daraus: Mein Job war immer schon regelhaft und damit formalisierbar, in einen Algorithmus übersetzbar und damit automatisierbar – eine Homologie die Bettina Heintz aufgezeigt hat (Heintz). Es war uns nur vorher nicht klar, oder die Technik war noch nicht bereit.

So galt Kopfrechnen lange Zeit als ausschließliche Domäne menschlicher Geistestätigkeit – wie Schach spielen, Kreditberatung oder Informationsbeschaffung. Doch nur so lange, bis eine Maschine in der Lage war, diese Tätigkeiten auszuführen, woraufhin sich die Definition, was denn nun genuin menschliche kognitive Betätigung ausmache, entsprechend nachjustierte. Bis vor kurzem galt das Zusammenfassen wissenschaftlicher Texte als Kennzeichen menschlicher Intelligenz, das ist jetzt vorbei. Benanav vermutet, dass ChatGPT am Stärksten spürbar werden wird bei «Computerprogrammierung, technischem sowie juristischem Schreiben» (Benanav 2023).

Immer wieder verschiebt sich so die Grenze des technisch Machbaren– eine Grundeigenschaft jeder technologischen Entwicklung im Kapitalismus.

Das Beispiel Copilot – your AI pair programmer

GitHub Copilot ist eine Anwendung, die Programmierer*innen mit Codierungsvorschlägen in Echtzeit hilft. Während des Programmierens wartet sie mit Vorschlägen für einzelne Zeilen, Funktionen und sogar komplette Lösungen für in natürlicher Sprache (Englisch) formulierte Programmieranforderungen. GitHub Copilot basiert – ähnlich oder sogar analg zu ChatGPT – auf einem generativen vortrainierten Sprachmodell, das von OpenAI erstellt wurde (Codex). Es wurde mit Text und Quellcode aus öffentlich zugänglichen Quellen trainiert, einschließlich Code in öffentlichen Repositories auf GitHub.

Git ist ein frei verfügbares Versionierungstool, das die kollaborative Codeentwicklung mit der Protokollierung des Versionsverlaufs kombiniert. Es wurde 2005 vom Linux-Erfinder Linus Torvalds initiiert. Git kann durchaus als eine der wichtigsten Innovationen in der Softwareentwicklung der letzten Jahre gelten. Das Hosting der mit Git produzierten Codes geschieht in sogenannten Repositories. Seit 2008 bietet das kleine Start-up GitHub diese Dienstleistung gegen eine kleine Gebühr an, der Dienst ist für nicht-kommerzielle Projekte kostenlos. Git-Hub wurde schnell zum bevorzugten Anbieter für die Entwicklerszene, eine Art Wikipedia für Programmiercode (Jan Mahn 2018, Microsoft kauft GitHub, in: c't 14/2018, S. 40, Kaufartikel) mit inzwischen 73 Millionen User und 2500 Beschäftigten weltweit.

Im Dezember 2018 wurde das in San Francisco ansässige Unternehmen GitHub, Inc. von Microsoft für 7,5 Milliarden Dollar übernommen. Die Branche war einigermaßen überrascht: Was will der Software-Gigant Microsoft, der wie kein anderer für das Modell proprietärer Software steht, mit dem kleinen, als Open-Source verschriebenen Git-Hub, fragten sich viele in der Branche.

Die Antwort liegt nun in Form von Copilot vor. GitHub hat Zugriff auf die weltweit größte Codebasis in Hunderten von Programmiersprachen, die jemals zusammengestellt wurden. Microsoft hat diesen Schatz nun gehoben, maschinelle Lernalgorithmen ins Spiel, um die Arbeit von Millionen von Programmierern beim Extrahieren von Informationen aus ihren Repositories zu ernten. Und aus dem frei verfügbaren akkumulierten Wissen der weltweiten Hacker- bzw. Coder-Klasse (McKenzie Wark), eine Anwendung erstellt, die nun den einzelnen Programmierer*innen als – vermutlich bald unverzichtbares – digitales Helferlein dient – unter der Regie des Digitalkonzerns Microsoft. Beworben wird copilot als «Programmier-Kumpel», als maschineller Begleiter in allen Programmierer*innen-Lebenslagen. Es nimmt damit implizit Bezug auf die Technik des extreme programming, bei der zwei Menschen eng an ein- und demselben Problem arbeiten (Wikipedia: Extreme Programmierung).

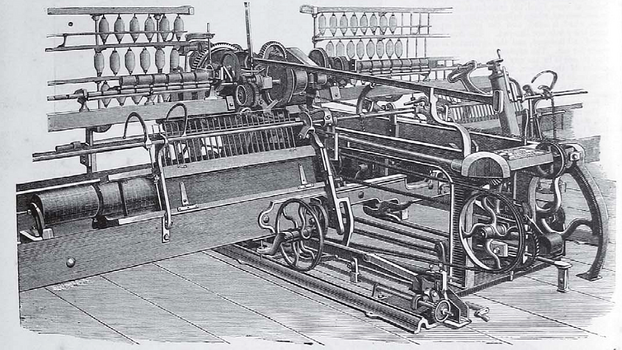

Copilot demonstriert meinen letzten Punkt: Algorithmen für maschinelles Lernen sind die neueste Maschine des digitalen Kapitals in seinem Streben nach Gewinnmaximierung. Insofern ähnelt sie eher Marx‘ self-acting mule als gängigen Vorstellungen von «Künstlicher Intelligenz».

Quellen

- «Traum und Alptraum». Forum, 14.04.2023.

- Alpaydin, Ethem (2016): Machine Learning. The new AI, Cambridge, MA.

- Benanav, Aaron: «The revolution will not be brought to you by ChatGPT. Robots never took your job, and neither will chatbots.» In: New Statesman, 11.4.2023.

- Boes, Andreas; Kämpf, Tobias: «Informatisierung und Informationsraum. Eine Theorie der digitalen Transformation». In: Simon Schaupp, Theorien des digitalen Kapitalismus, Suhrkamp, Berlin 2023.

- Daum, Timo: Die Künstliche Intelligenz des Kapitals, Hamburg 2020.

- Domingos, Pedro: The Master Algorithm: How the Quest for the Ultimate Learning Machine Will Remake Our World. New York: Basic books, 2018.

- Eder, Barbara: Das Denken Der Maschine: Marx, Mumford, Simondon. Wien: Mandelbaum, 2023.

- Heaven, Will Douglas: «ChatGPT is everywhere. Here’s where it came from». MIT Technology Review, 8.2.2023,

- Langley, Pat: «The Cognitive Systems Paradigm». In: Advances in Cognitive Systems 1 (2012), S. 3–13.

- Lee, Kai-Fu: AI superpowers: China, Silicon Valley, and the New World Order. Houghton Mifflin Harcourt, Boston 2018.

- Lotz, Christian: Maschinenfragment, Hamburg 2014.

- Mahn, Jan (2018): Microsoft kauft GitHub, in: c't 14/2018, S. 40 (Bezahlinhalt).

- Mahn, Jan: «Microsoft kauft GitHub». In: c't 14/2018, S. 40.

- Marx, Karl: Grundrisse, MEW Bd. 42, S. 606

- Morozov, Evgeny: «The problem with artificial intelligence? It’s neither artificial nor intelligent». In: The Guardian, 30.3.2023.

- Pasquinelli, Matteo: «Google’s PageRank Algorithm: A Diagram of the Cognitive Capitalism and the Rentier of the Common Intellect». In: Becker, Konrad; Stalder, Felix (Hrsg.): Deep Search: The Politics of Search Beyond Google, London: Transaction Publishers, 2009.

- Pistor, Katharina: Der Code des Kapitals: Wie das Recht Reichtum und Ungleichheit schafft. Berlin: Suhrkamp, 2021.

- Schneider, Julia; Ziyal, Lena: «We Need to Talk, AI – A Comic Essay on Artificial Intelligence», weneedtotalk.ai.

- Srnicek, Nick (2019): Keynote: The Political Economy of Artificial Intelligence Kolleg Postwachstum, «Konferenz: Great Transformation // Keynote». YouTube.

- Toh, Michelle (2023): 300 million jobs could be affected by latest wave of AI, says Goldman Sachs. CNN, 29.3.2023.

- Victor, Jon and Aaron Holmes, «OpenAI Is Making Headlines. It’s Also Seeding Talent Across Silicon Valley». theinformation.com, 1.2.2023.

- Wikipedia: Extreme Programmierung.

- Zuboff, Shoshana: Das Zeitalter des Überwachungskapitalismus. Campus Verlag, Frankfurt , New York 2018.